- ავტორი Lynn Donovan [email protected].

- Public 2023-12-15 23:49.

- ბოლოს შეცვლილი 2025-01-22 17:29.

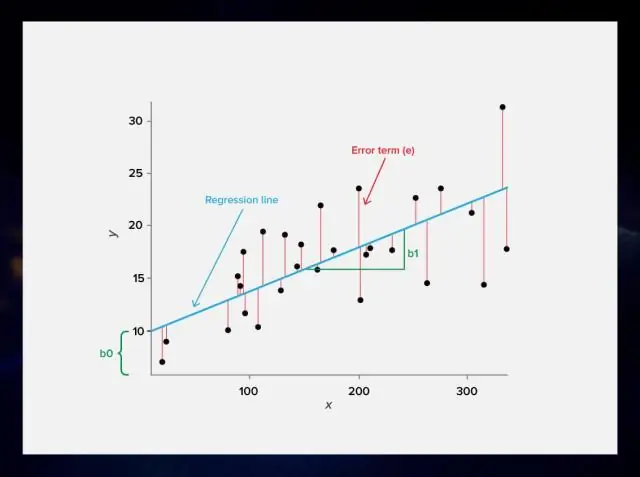

რეგულარიზაცია . ეს არის ფორმა რეგრესია , რომელიც ზღუდავს/არეგულირებს ან ამცირებს კოეფიციენტების შეფასებას ნულამდე. სხვა სიტყვებით რომ ვთქვათ, ეს ტექნიკა ხელს უშლის უფრო რთული ან მოქნილი სწავლის საშუალებას მოდელი ზედმეტად მორგების რისკის თავიდან ასაცილებლად. მარტივი ურთიერთობა ხაზოვანი რეგრესია ასე გამოიყურება.

შესაბამისად, რა არის ლამბდა ხაზოვან რეგრესიაში?

როცა მაღალი ხარისხი გვაქვს ხაზოვანი მრავალწევრი, რომელიც გამოიყენება a-ში წერტილების სიმრავლის მოსაწყობად ხაზოვანი რეგრესია დაყენება, ზედმეტი მორგების თავიდან ასაცილებლად, ჩვენ ვიყენებთ რეგულარიზაციას და ვიცავთ ა ლამბდა პარამეტრი ღირებულების ფუნქციაში. ეს ლამბდა შემდეგ გამოიყენება გრადიენტული დაღმართის ალგორითმში თეტა პარამეტრების გასაახლებლად.

მეორეც, რა არის რეგულარიზაციის მიზანი? რეგულარიზაცია არის ტექნიკა, რომელიც გამოიყენება რეგულირებისთვის ფუნქცია შეცდომაში დამატებითი საჯარიმო ვადის დამატებით ფუნქცია . დამატებითი ტერმინი აკონტროლებს ზედმეტად მერყეობას ფუნქცია ისეთი, რომ კოეფიციენტებმა არ მიიღონ უკიდურესი მნიშვნელობები.

ამგვარად, რატომ გვჭირდება რეგრესიის დარეგულირება?

მიზანი რეგულაცია სხვა სიტყვებით რომ ვთქვათ, არის ზედმეტი მორგების თავიდან აცილება ჩვენ ცდილობენ თავიდან აიცილონ მოდელები, რომლებიც ძალიან კარგად ერგება ტრენინგის მონაცემებს (მონაცემები, რომლებიც გამოიყენება მოდელის შესაქმნელად), მაგრამ ცუდად ერგება ტესტირების მონაცემებს (მონაცემები გამოიყენება იმის შესამოწმებლად, თუ რამდენად კარგია მოდელი). ეს ცნობილია, როგორც overfitting.

რას ნიშნავს რეგულაცია?

მათემატიკაში, სტატისტიკასა და კომპიუტერულ მეცნიერებაში, განსაკუთრებით მანქანათმცოდნეობაში და შებრუნებულ ამოცანებში, რეგულაცია არის ინფორმაციის დამატების პროცესი არასწორად დასმული პრობლემის გადასაჭრელად ან ზედმეტი მორგების თავიდან ასაცილებლად. რეგულარიზაცია ვრცელდება ობიექტურ ფუნქციებზე ცუდად დასმულ ოპტიმიზაციის პრობლემებში.

გირჩევთ:

რა არის ხაზოვანი ბლოკის კოდის განმარტება?

წრფივი ბლოკის კოდი არის ბლოკის კოდი, რომელშიც ექსკლუზიური ან ნებისმიერი ორი კოდის სიტყვა იწვევს სხვა კოდურ სიტყვას

რა არის ML რეგრესია?

რეგრესია არის ML ალგორითმი, რომლის მომზადებაც შესაძლებელია რეალური დანომრილი შედეგების პროგნოზირებისთვის; როგორიცაა ტემპერატურა, აქციების ფასი და ა.შ. რეგრესია ეფუძნება ჰიპოთეზას, რომელიც შეიძლება იყოს წრფივი, კვადრატული, პოლინომიური, არაწრფივი და ა.შ. ჰიპოთეზა არის ფუნქცია, რომელიც ეფუძნება ზოგიერთ ფარულ პარამეტრს და შეყვანის მნიშვნელობებს

რა არის ხაზოვანი მონაცემთა ტიპები?

მონაცემთა ხაზოვანი სტრუქტურების მაგალითებია Arrays, Stack, Queue და Linked List. მასივები არის მონაცემთა ერთეულების კოლექცია, რომლებსაც აქვთ იგივე ტიპის მონაცემთა ტიპები. Stack არის LIFO (Last In First Out) მონაცემთა სტრუქტურა, სადაც ელემენტი, რომელიც ბოლოს დაემატა, პირველი წაიშლება. დასტაზე ყველა ოპერაცია შესრულებულია ბოლოდან, სახელწოდებით TOP

არის თუ არა გადაწყვეტილების ხე რეგრესია?

გადაწყვეტილების ხე - რეგრესია. გადაწყვეტილების ხე აშენებს რეგრესიის ან კლასიფიკაციის მოდელებს ხის სტრუქტურის სახით. ყველაზე მაღალი გადაწყვეტილების კვანძი ხეში, რომელიც შეესაბამება საუკეთესო პროგნოზს, რომელსაც ეწოდება root კვანძი. გადაწყვეტილების ხეებს შეუძლიათ გაუმკლავდნენ როგორც კატეგორიულ, ასევე ციფრულ მონაცემებს

რა არის ხაზოვანი ბლოკის კოდი?

კოდირების თეორიაში, წრფივი კოდი არის შეცდომის გამოსწორების კოდი, რომლისთვისაც კოდის სიტყვების ნებისმიერი ხაზოვანი კომბინაცია ასევე არის კოდის სიტყვა. წრფივი ბლოკის კოდის კოდური სიტყვები არის სიმბოლოების ბლოკები, რომლებიც დაშიფრულია უფრო მეტი სიმბოლოს გამოყენებით, ვიდრე ორიგინალური მნიშვნელობა