- ავტორი Lynn Donovan [email protected].

- Public 2023-12-15 23:49.

- ბოლოს შეცვლილი 2025-01-22 17:29.

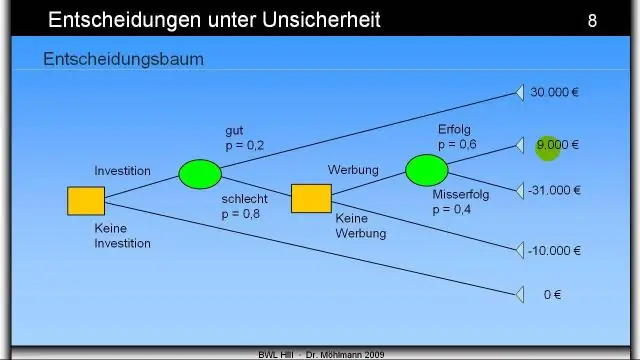

სიზუსტე : სწორი პროგნოზების რაოდენობა გაყოფილი პროგნოზების საერთო რაოდენობაზე. ჩვენ ვაპირებთ ვიწინასწარმეტყველოთ უმრავლესობის კლასი, რომელიც დაკავშირებულია კონკრეტულ კვანძთან, როგორც True. ე.ი. გამოიყენეთ უფრო დიდი მნიშვნელობის ატრიბუტი თითოეული კვანძიდან.

გარდა ამისა, როგორ შეგიძლიათ გააუმჯობესოთ გადაწყვეტილების ხის სიზუსტე?

ახლა ჩვენ გადავხედავთ მოდელის სიზუსტის გაუმჯობესების დადასტურებულ გზას:

- დაამატეთ მეტი მონაცემები. მეტი მონაცემების ქონა ყოველთვის კარგი იდეაა.

- დაამუშავეთ დაკარგული და Outlier მნიშვნელობები.

- მხატვრული ინჟინერია.

- მახასიათებლის შერჩევა.

- მრავალი ალგორითმი.

- ალგორითმის რეგულირება.

- ანსამბლის მეთოდები.

ანალოგიურად, რა არის გადაწყვეტილების ხე და მაგალითი? გადაწყვეტილების ხეები არის ზედამხედველობითი მანქანური სწავლების ტიპი (ანუ თქვენ ახსნით რა არის შეყვანა და რა არის შესაბამისი გამომავალი ტრენინგის მონაცემებში), სადაც მონაცემები მუდმივად იყოფა გარკვეული პარამეტრის მიხედვით. ან მაგალითი ა გადაწყვეტილების ხე შეიძლება აიხსნას ზემოთ მოყვანილი ბინარის გამოყენებით ხე.

ამასთან დაკავშირებით, როგორ მუშაობს გადაწყვეტილების ხეები?

გადაწყვეტილების ხე აგებს კლასიფიკაციის ან რეგრესიის მოდელებს ა-ს სახით ხე სტრუქტურა. ის ანაწილებს მონაცემთა კომპლექტს უფრო და უფრო მცირე ქვეჯგუფებად და ამავე დროს ასოცირდება გადაწყვეტილების ხე თანდათან ვითარდება. ა გადაწყვეტილება კვანძს აქვს ორი ან მეტი ტოტი. ფოთლის კვანძი წარმოადგენს კლასიფიკაციას ან გადაწყვეტილება.

რა არის გადაჭარბებული მორგება გადაწყვეტილების ხეში?

ზედმეტად მორგება ეს არის ფენომენი, რომლის დროსაც სასწავლო სისტემა მჭიდროდ ერგება მოცემულ სასწავლო მონაცემებს ისე, რომ არაზუსტი იქნებოდა მოუმზადებელი მონაცემების შედეგების პროგნოზირებაში. In გადაწყვეტილების ხეები , ზედმეტად მორგება ხდება მაშინ, როდესაც ხე შექმნილია ისე, რომ სრულყოფილად მოერგოს ყველა ნიმუშს სასწავლო მონაცემთა ნაკრებში.

გირჩევთ:

როგორ მუშაობს გადაწყვეტილების ხე R-ში?

გადაწყვეტილების ხე არის ზედამხედველობითი სწავლის ალგორითმის ტიპი, რომელიც შეიძლება გამოყენებულ იქნას როგორც რეგრესიის, ასევე კლასიფიკაციის პრობლემების დროს. ის მუშაობს როგორც კატეგორიული, ასევე უწყვეტი შეყვანის და გამომავალი ცვლადებისთვის. როდესაც ქვეკვანძი იყოფა შემდგომ ქვეკვანძებად, მას უწოდებენ გადაწყვეტილების კვანძს

როგორ ხვდებით ანდერვუდის საბეჭდ მანქანას?

შეხედეთ გასაღებების რიგებს თქვენს მოდელზე. პორტატული საბეჭდი მანქანები, რომლებიც ოდნავ პატარა იყო, მათი გასაღებით შეიძლება დათარიღდეს. თუ თქვენს პორტატულ მოდელს აქვს სამი რიგი, ეს არის 1919 წლიდან 1929 წლამდე; თუ მას აქვს ოთხი რიგი, ეს არის 30-იანი ან 40-იანი წლების. შეამოწმეთ სერიული ნომერი საბეჭდი მანქანის ეტლის ქვეშ

რა არის გადაწყვეტილების ხის სიღრმე?

გადაწყვეტილების ხის სიღრმე არის ყველაზე გრძელი ბილიკის სიგრძე ფესვიდან ფოთლამდე. გადაწყვეტილების ხის ზომა არის ხეში არსებული კვანძების რაოდენობა. გაითვალისწინეთ, რომ თუ გადაწყვეტილების ხის თითოეული კვანძი მიიღებს ორობით გადაწყვეტილებას, ზომა შეიძლება იყოს 2d+1&მინუს;1, სადაც d არის სიღრმე

რა ტიპის პრობლემებია საუკეთესოდ შეეფერება გადაწყვეტილების ხის შესწავლას?

გადაწყვეტილების ხის სწავლის შესაბამისი პრობლემები გადაწყვეტილების ხის სწავლება, როგორც წესი, საუკეთესოდ შეეფერება შემდეგ მახასიათებლებს: ინსტანციები წარმოდგენილია ატრიბუტ-მნიშვნელობის წყვილებით. არსებობს ატრიბუტების სასრული სია (მაგ. თმის ფერი) და თითოეული მაგალითი ინახავს ამ ატრიბუტის მნიშვნელობას (მაგ. ქერა)

როგორ ხვდებით შეცდომებს კვანძში JS?

თქვენ ასევე უნდა იცოდეთ Node-ში შეცდომის მიწოდების ოთხი ძირითადი გზა. js: ჩააგდეთ შეცდომა (რაც გამონაკლისია). შეცდომის გადაცემა გამოძახებაზე, ფუნქცია, რომელიც სპეციალურად არის გათვალისწინებული შეცდომებისა და ასინქრონული ოპერაციების შედეგების მოსაგვარებლად