Სარჩევი:

- ავტორი Lynn Donovan [email protected].

- Public 2023-12-15 23:49.

- ბოლოს შეცვლილი 2025-01-22 17:29.

Შეგროვება (მოქმედება) - დააბრუნეთ მონაცემთა ნაკრების ყველა ელემენტი მასივის სახით მძღოლის პროგრამაში. ეს ჩვეულებრივ სასარგებლოა ფილტრის ან სხვა ოპერაციის შემდეგ, რომელიც აბრუნებს მონაცემთა საკმარისად მცირე ქვეჯგუფს.

ამ გზით, რა არის PySpark?

PySpark პროგრამირება. PySpark არის Apache Spark-ისა და Python-ის თანამშრომლობა. Apache Spark არის ღია კოდის კლასტერული გამოთვლითი ჩარჩო, რომელიც აგებულია სიჩქარის, გამოყენების სიმარტივის და ნაკადის ანალიტიკის გარშემო, ხოლო Python არის ზოგადი დანიშნულების, მაღალი დონის პროგრამირების ენა.

ასევე, რა არის რუკა PySpark-ში? ნაპერწკალი რუკა ტრანსფორმაცია. ა რუკა არის ტრანსფორმაციის ოპერაცია Apache Spark-ში. ის ვრცელდება RDD-ის თითოეულ ელემენტზე და ის აბრუნებს შედეგს, როგორც ახალი RDD. რუკა გარდაქმნის N სიგრძის RDD-ს N სიგრძის სხვა RDD-ად. შემავალ და გამომავალ RDD-ებს, როგორც წესი, ექნებათ ჩანაწერების იგივე რაოდენობა.

ამ გზით, რა არის SparkContext PySpark-ში?

PySpark - SparkContext . რეკლამები. SparkContext არის ნებისმიერი შესვლის წერტილი ნაპერწკალი ფუნქციონირება. როცა რომელიმეს ვატარებთ ნაპერწკალი აპლიკაცია იწყება დრაივერის პროგრამა, რომელსაც აქვს მთავარი ფუნქცია და თქვენი SparkContext აქ იწყება. შემდეგ დრაივერების პროგრამა აწარმოებს ოპერაციებს შემსრულებლების შიგნით მუშა კვანძებზე.

როგორ შევამოწმო PySpark ვერსია?

2 პასუხი

- გახსენით Spark shell Terminal და შეიყვანეთ ბრძანება.

- sc.version ან spark-submit --ვერსია.

- უმარტივესი გზაა უბრალოდ გაუშვათ "spark-shell" ბრძანების ხაზში. ის აჩვენებს.

- Spark-ის მიმდინარე აქტიური ვერსია.

გირჩევთ:

რა არის w3c რა არის Whatwg?

Web Hypertext Application Technology Working Group (WHATWG) არის HTML და მასთან დაკავშირებული ტექნოლოგიების განვითარებაში დაინტერესებული ადამიანების საზოგადოება. WHATWG დაარსდა Apple Inc.-ის, Mozilla Foundation-ის და Opera Software-ის, წამყვანი ვებ ბრაუზერების მომწოდებლების მიერ 2004 წელს

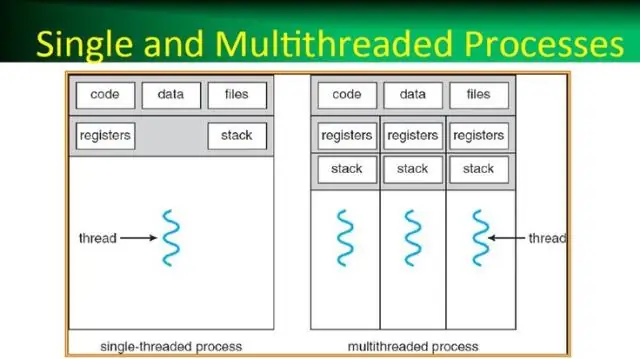

რა არის პროცესი ოპერაციულ სისტემაში, რა არის ძაფი ოპერაციულ სისტემაში?

პროცესი, უმარტივესი სიტყვებით, არის შემსრულებელი პროგრამა. ერთი ან მეტი თემა გადის პროცესის კონტექსტში. ძაფი არის ძირითადი ერთეული, რომელსაც ოპერაციული სისტემა ანაწილებს პროცესორის დროს. Threadpool ძირითადად გამოიყენება აპლიკაციების ძაფების რაოდენობის შესამცირებლად და სამუშაო ძაფების მართვის უზრუნველსაყოფად

რა არის უჯრედების მითითება და რა არის სხვადასხვა ტიპის მითითება?

არსებობს ორი ტიპის უჯრედის მითითება: ფარდობითი და აბსოლუტური. ფარდობითი და აბსოლუტური მითითებები განსხვავებულად იქცევა სხვა უჯრედებში კოპირებისა და შევსებისას. ფარდობითი მიმართვები იცვლება, როდესაც ფორმულა კოპირდება სხვა უჯრედში. მეორეს მხრივ, აბსოლუტური მითითებები მუდმივი რჩება, სადაც არ უნდა იყოს კოპირებული

როგორ გავაკეთო PySpark DataFrame სიიდან?

მე მივყვები ამ ნაბიჯებს DataFrame-ის შესაქმნელად tuples-ის სიიდან: შექმენით ტოპების სია. თითოეული ტილო შეიცავს ასაკის პირის სახელს. შექმენით RDD ზემოთ მოცემული სიიდან. გადააკეთეთ თითოეული ტოპი მწკრივად. შექმენით DataFrame RDD-ზე createDataFrame-ის გამოყენებით sqlContext-ის დახმარებით

რა არის მწკრივი PySpark-ში?

მწკრივი SchemaRDD-ში. მასში შემავალი ველების წვდომა შესაძლებელია ატრიბუტების მსგავსად. მწკრივი შეიძლება გამოყენებულ იქნას მწკრივის ობიექტის შესაქმნელად დასახელებული არგუმენტების გამოყენებით, ველები დალაგდება სახელების მიხედვით