- ავტორი Lynn Donovan [email protected].

- Public 2023-12-15 23:49.

- ბოლოს შეცვლილი 2025-01-22 17:29.

ხოლო ნაპერწკალი მხარს უჭერს დატვირთვას ფაილები დან ადგილობრივი ფაილური სისტემა, ის მოითხოვს, რომ ფაილები ხელმისაწვდომია იმავე გზაზე თქვენი კლასტერის ყველა კვანძზე. ზოგიერთი ქსელის ფაილური სისტემა, როგორიცაა NFS, AFS და MapR-ის NFS ფენა, ექვემდებარება მომხმარებელს, როგორც ჩვეულებრივი ფაილური სისტემა.

შემდგომში შეიძლება ისიც იკითხოს, როგორ გავატარო spark ლოკალურ რეჟიმში?

In ლოკალური რეჟიმი , ნაპერწკალი სამუშაო ადგილები გაშვება ერთ მანქანაზე და შესრულებულია პარალელურად მრავალ ძაფების გამოყენებით: ეს ზღუდავს პარალელიზმს (მაქსიმუმ) თქვენი აპარატის ბირთვების რაოდენობაზე. რომ გაშვება სამუშაო ადგილები ლოკალური რეჟიმი , ჯერ უნდა დაჯავშნოთ მანქანა SLURM-ის საშუალებით ინტერაქტიულად რეჟიმი და შედით მასში.

გარდა ზემოთ, რა არის SC textFile? textFile არის მეთოდი ორგ. აპაჩი. SparkContext კლასი, რომელიც კითხულობს ა ტექსტური ფაილი HDFS-დან, ლოკალური ფაილური სისტემიდან (ხელმისაწვდომია ყველა კვანძზე) ან Hadoop-ის მხარდაჭერილი ფაილური სისტემის URI-დან და დააბრუნეთ იგი სტრიქონების RDD-ად.

ამასთან დაკავშირებით, რა არის spark ფაილი?

The Spark ფაილი არის დოკუმენტი, სადაც თქვენ ინახავთ მთელ თქვენს შემოქმედებით სიკეთეს. იგი განსაზღვრა ავტორმა სტივენ ჯონსონმა. ასე რომ, იმის ნაცვლად, რომ შუაღამისას პოსტ-it®-ზე ჩანაწერები დაწეროთ ან იდეებისთვის სხვადასხვა ჟურნალი დაუთმოთ, თქვენ ყველა კონცეფციას ერთში აყენებთ. ფაილი.

რა არის პარალელიზებული შეგროვების ნაპერწკალი?

ჩვენ აღვწერთ ოპერაციებს განაწილებულ მონაცემთა ნაკრებებზე მოგვიანებით. პარალელიზებული კოლექციები იქმნება JavaSparkContext-ის გამოძახებით პარალელიზება მეთოდი არსებულზე კოლექცია თქვენს მძღოლის პროგრამაში. ელემენტები კოლექცია კოპირებულია განაწილებული მონაცემთა ნაკრების შესაქმნელად, რომლის პარალელურად მუშაობა შესაძლებელია.

გირჩევთ:

შეუძლია თუ არა პითონს ZIP ფაილების წაკითხვა?

პითონის გამოყენებით zip ფაილებზე სამუშაოდ, ჩვენ გამოვიყენებთ ჩაშენებულ პითონის მოდულს, სახელწოდებით zipfile. ბეჭდვა („შესრულებულია!“ZipFile არის zipfile მოდულის კლასი zip ფაილების წაკითხვისა და ჩაწერისთვის. აქ ჩვენ იმპორტირებთ მხოლოდ ZipFile კლასს zipfile მოდულიდან

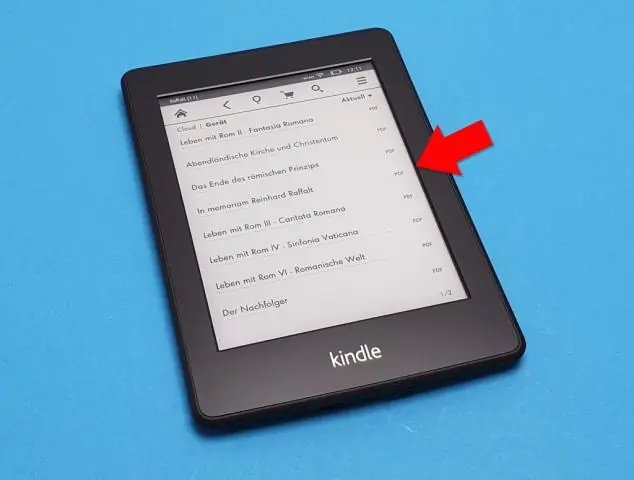

შეიძლება თუ არა საბოლოო PDF ფაილების წაკითხვა?

პრო-რჩევა: თქვენ ასევე შეგიძლიათ გახსნათ ფაილი Finale-ში ფაილის არჩევით საპოვნელში და მარჯვენა ღილაკით. შემდეგ აირჩიეთ „გახსნა…“და აირჩიეთ Finale პროგრამის ზოლში. გილოცავ! თქვენ წარმატებით შემოიტანეთ PDF ფაილი Finale-ში ScanScore-ის გამოყენებით

შეგიძლიათ კუთხეში PDF ფაილების წაკითხვა?

დოკუმენტები, რომლებიც შეგიძლიათ დაამატოთ Nookinclude PDF-ებს, რომლებიც შეიძლება იყოს წიგნები ან სხვა მოკლე დოკუმენტები. Nook-ზე PDF-ების წაკითხვა შესაძლებელია ისევე, როგორც ნებისმიერი სხვა შეძენილი წიგნი, და შეგიძლიათ მოწყობილობის სინქრონიზაცია, დოკუმენტების კოპირება თქვენი კომპიუტერიდან Nook-ში. ორჯერ დააწკაპუნეთ "წიგნები" ან "დოკუმენტები" საქაღალდეზე თქვენი Nook-ის დისკზე

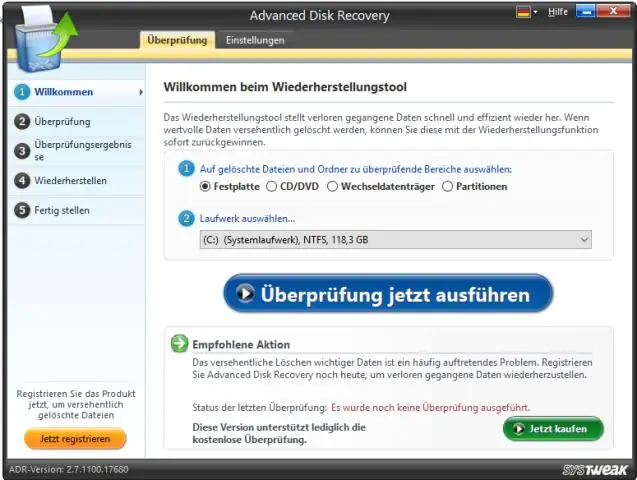

შეუძლია Windows 10-ს დაუმუშავებელი ფაილების წაკითხვა?

Windows 10 არ იგზავნება დაუმუშავებელი გამოსახულების ფაილების გადახედვისთვის, რაც იმას ნიშნავს, რომ მომხმარებლებს არ შეუძლიათ ნახონ ესკიზები ან მეტამონაცემები Photos-ში ან Windows File Explorer-ში. თუმცა, Microsoft-ს აქვს გამოსავალი ფოტოგრაფებისთვის, რომლებსაც ესაჭიროებათ ეს შესაძლებლობა და მას უწოდებენ Raw Image Extension

შეუძლია Windows-ს HEIC ფაილების წაკითხვა?

HEIF გამოსახულების გაფართოება საშუალებას აძლევს Windows 10 მოწყობილობებს წაიკითხონ და დაწერონ ფაილები, რომლებიც იყენებენ HighEfficiency Image File (HEIF) ფორმატს. ასეთ ფაილებს შეიძლება ჰქონდეს ა. ჰეიკი ან. თუ HEVC Video Extensionspackage არ არის დაინსტალირებული, HEIF Image Extension ვერ შეძლებს წაკითხვას ან წერას